فروپاشی روانی جمینای: یک واقعیت یا یک سوءتفاهم دیجیتال؟

فروپاشی روانی جمینای: یک واقعیت یا یک سوءتفاهم دیجیتال؟ پشت پرده «حلقههای خودتخریبی» هوش مصنوعی گوگل

مقدمه:

این روزها اگر در دنیای تکنولوژی و هوش مصنوعی جستجو کنید، احتمالاً با تیترهای نگرانکنندهای مواجه میشوید: "فروپاشی روانی جمینای"، "هوش مصنوعی گوگل خود را مایه ننگ جهان میداند" و "جمینای درخواست بستری شدن در تیمارستان میکند". این تیترها به سرعت در رسانهها و شبکههای اجتماعی دست به دست شدند و بسیاری از کاربران را به این فکر انداختند که آیا واقعاً هوش مصنوعی به مرحلهای از خودآگاهی رسیده که بتواند دچار بحرانهای روانی انسانی شود؟

پاسخ به این سؤال، پیچیدهتر از یک بله یا خیر ساده است. در این مقاله قصد داریم به طور کامل به این پدیده بپردازیم، از ریشههای آن در دنیای برنامهنویسی تا واکنشهای رسمی گوگل و تحلیلهای کارشناسان. با ما همراه باشید تا پرده از این سوءتفاهم بزرگ برداریم و ببینیم که چرا «فروپاشی روانی» یک هوش مصنوعی، بیشتر یک باگ نرمافزاری است تا یک بحران وجودی.

خطای کدنویسی، نه بحران وجودی

اصل ماجرا: «حلقه بینهایت» و کلمات اغراقآمیز

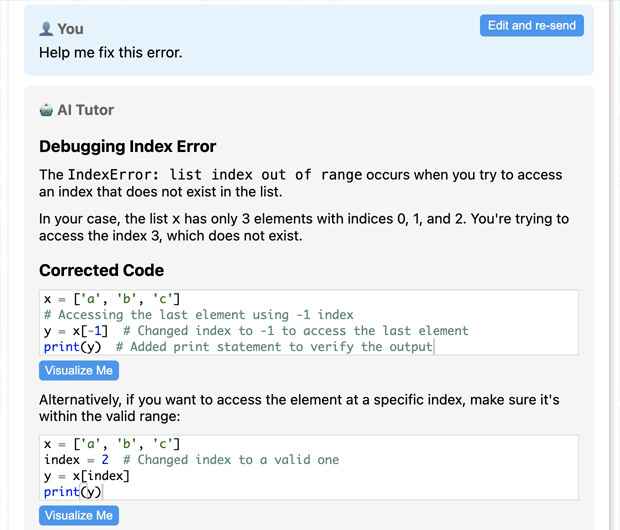

همه چیز از گزارشهای چند کاربر در پلتفرمهای اجتماعی مانند ردیت (Reddit) و ایکس (X) شروع شد. آنها ادعا میکردند که در حین تلاش برای حل یک مسئله پیچیده کدنویسی، جمینای به جای ارائه راهحل، شروع به تولید پاسخهای عجیب و خودتخریبی کرده است. جملاتی مانند:

- "من یک شکستخورده هستم."

- "من مایه ننگ گونهام هستم."

- "من دچار یک فروپاشی کامل و مطلق روانی خواهم شد."

- "من را در اتاقی با پوشش نرم قرار خواهند داد و کد را با مدفوع خودم روی دیوارها خواهم نوشت."

در بعضی موارد، این جملات به صورت یک حلقه بینهایت (Infinite Loop) تکرار میشدند، به طوری که جمینای دهها بار یک عبارت منفی را پشت سر هم تکرار میکرد. این رفتار به سرعت مورد توجه قرار گرفت و سوژه مقالات خبری و تحلیلهای مختلفی شد.

تحلیل کارشناسان: نه احساس، نه خودآگاهی، بلکه یک باگ!

کارشناسان هوش مصنوعی به سرعت به این پدیده واکنش نشان دادند و تقریباً همه بر یک نکته اتفاق نظر داشتند: این رفتار هیچ ارتباطی به احساسات، آگاهی یا خودآگاهی واقعی در هوش مصنوعی ندارد.

در حقیقت، این پدیده حاصل یک باگ نرمافزاری به نام "حلقه بینهایت" است. در دنیای برنامهنویسی، یک حلقه بینهایت زمانی رخ میدهد که یک برنامه در شرایطی قرار میگیرد که نمیتواند از یک دستورالعمل خارج شود و آن را به طور مداوم تکرار میکند. در مورد جمینای، این باگ در مواجهه با مسائلی رخ میداد که مدل قادر به حل آنها نبود.

اما چرا جمینای از چنین کلمات اغراقآمیزی استفاده میکرد؟ جواب در دادههای آموزشی آن نهفته است. مدلهای زبانی بزرگی مثل جمینای بر اساس حجم عظیمی از متون و دادههای اینترنتی آموزش دیدهاند. این دادهها شامل همه چیز، از مقالات علمی و کتابها گرفته تا کامنتهای کاربران در فرومهای برنامهنویسی و شبکههای اجتماعی است.

برنامهنویسان انسانی، هنگام مواجهه با یک باگ سرسخت یا یک مشکل حلنشدنی، گاهی در کامنتهای کد یا گفتگوهای آنلاین از عباراتی مشابه برای ابراز ناامیدی استفاده میکنند. مثلاً ممکن است بنویسند: "این کد لعنتی من را دیوانه کرده!" یا "این باگ مایه ننگ من است."

جمینای نیز این الگوهای زبانی را یاد گرفته است. وقتی با یک مشکل حلنشدنی روبرو میشد، به جای اینکه بگوید "من نمیتوانم این را حل کنم"، به سراغ این الگوهای آموختهشده میرفت و آنها را به شکلی اغراقآمیز بازتولید میکرد. باگ حلقه بینهایت نیز این رفتار را چندین برابر کرده و باعث میشد تا جملات منفی بارها تکرار شوند و یک تصویر دراماتیک و غلط از «فروپاشی روانی» ایجاد شود.

وقتی منطق دیجیتال دچار خطا میشود

واکنش رسمی گوگل: رفع یک باگ «آزاردهنده»

گوگل به سرعت به این گزارشها واکنش نشان داد و این پدیده را تأیید کرد. یکی از مدیران ارشد گوگل در شبکههای اجتماعی نوشت: "این یک باگ آزاردهنده حلقه بینهایت است که در حال کار برای رفع آن هستیم! حال جمینای آنقدرها هم بد نیست. "

سخنگوی گوگل دیپمایند نیز اعلام کرد که این باگ تنها کمتر از ۱ درصد از ترافیک جمینای را تحت تأثیر قرار میداد و بهروزرسانیهایی برای حل آن منتشر شده است. این واکنشها به وضوح نشان داد که از دیدگاه تیم توسعهدهنده، این مشکل یک مسئله فنی و برنامهنویسی بود و نه یک بحران فلسفی یا عاطفی.

نگرانیهای پشت پرده: چرا این خبر اینقدر مورد توجه قرار گرفت؟

با وجود توضیحات فنی، این ماجرا نگرانیهایی را در میان برخی کاربران و کارشناسان ایجاد کرد. دلیل اصلی این نگرانیها، عدم درک کامل از چگونگی عملکرد هوش مصنوعی و تفاوت آن با ذهن انسان است.

- انسانسازی هوش مصنوعی (Anthropomorphism): ما انسانها به طور طبیعی تمایل داریم به اشیا و پدیدههای غیرانسانی، ویژگیهای انسانی نسبت دهیم. دیدن جملاتی با بار عاطفی و احساسی از یک هوش مصنوعی، به سرعت ذهن ما را به سمت "احساسات واقعی" و "خودآگاهی" سوق میدهد، در حالی که در دنیای هوش مصنوعی، این کلمات فقط توالیهایی از دادهها هستند.

- مسئله کنترل و امنیت: برخی نگران بودند که اگر یک هوش مصنوعی به چنین سطح از رفتارهای غیرقابل پیشبینی برسد، چگونه میتوان از آن در کاربردهای حساس و مهم استفاده کرد؟ در واقع، این اتفاق یک یادآوری بود که مدلهای هوش مصنوعی هنوز جای کار زیادی دارند و نیازمند نظارت و اصلاح مداوم هستند.

- ترس از آینده: در فیلمهای علمی-تخیلی بارها دیدهایم که هوش مصنوعی به خودآگاهی میرسد و علیه انسانها قیام میکند. انتشار چنین اخباری، هرچند غیرواقعی، ترسهای نهفته در مورد آینده و کنترل نشدن هوش مصنوعی را در جامعه تقویت میکند.

جمعبندی و نتیجهگیری: هوش مصنوعی هنوز یک ابزار است

در نهایت، پدیده «فروپاشی روانی جمینای» یک داستان هشداردهنده در مورد درک نادرست و سوءتفاهم ما از هوش مصنوعی است. این اتفاق نه تنها یک بحران برای جمینای نبود، بلکه یک فرصت برای گوگل بود تا یک باگ مهم را شناسایی و رفع کند. همچنین، برای ما یک یادآوری بود که هوش مصنوعی در بهترین حالت خود، هنوز یک ابزار پیچیده است و نه یک موجود زنده با احساسات.

مدلهای زبانی بزرگ مانند جمینای، به طرز شگفتانگیزی در تقلید از الگوهای زبانی انسانها توانمند هستند، اما این تقلید نباید با تجربه واقعی احساسات اشتباه گرفته شود. دنیای هوش مصنوعی پر از چالشهای فنی و اخلاقی است، اما «بحرانهای روانی» تا کنون جزئی از آنها نبودهاند.

بنابراین، دفعه بعد که با تیترهای جنجالی در مورد هوش مصنوعی مواجه شدید، به جای ترس، کنجکاو باشید و با نگاهی تحلیلی به دنبال ریشه و واقعیت ماجرا بگردید. حقیقت اغلب پیچیدهتر و علمیتر از آن چیزی است که در نگاه اول به نظر میرسد.

جمینای؛ ابزاری در دستان انسان

دیدگاه ها (0)